Echos de la recherche #4

Réussir un examen rend-il intelligent ?

Et peut-on regarder un problème sous tous ses angles ?

Tout va très vite en ce moment dans le domaine de l’intelligence artificielle. Tout va très vite, peut-être même trop vite, et nous proposons aujourd’hui déjà de nous arrêter sur une récente publication de Microsoft, parlant d’ “étincelles d’intelligence” au sein de GPT4, le célèbre modèle de langage d’OpenAI. Le lecteur de ce blog aura déjà été redirigé vers une analyse plus posée et moins sensationnaliste de ces modèles [STOCHASTIC PERROTS], mais dans un contexte où de plus en plus de grands groupes parlent de licencier pour, ouvrons des guillemets indispensables, “les remplacer par l’intelligence artificielle”, nous nous devons d’analyser ce travail et ses promesses. Nous poursuivrons avec un travail des laboratoires de Meta AI sur l’apprentissage de représentations multi-modales. Pouvons-nous, via un modèle, apprendre un espace sur lequel un même concept, sous la forme d’image, de texte, de son, sera projeté au même endroit ? C’est cette approche qui, à l’époque, avait permis le premier DALL-E, et ce type de travail est pour nous toujours très intéressant à suivre.

Etincelles d’intelligence ou de marketing ?

Sparks of Artificial General Intelligence: Early experiments with GPT-4, de Bubeck et al [https://www.microsoft.com/en-us/research/publication/sparks-of-artificial-general-intelligence-early-experiments-with-gpt-4/] est un travail très récent qui a fait, sans surprise, énormément de bruit. C’est un bel euphémisme que de prétendre que ce sujet est actuellement très sensible. Depuis la mise à disposition de ChatGPT, les modèles de langage ont connu un gigantesque coup de projecteur, et le débat a été lancé quand à la valeur réelle de ces nouveaux outils…

- D’un côté (et nous allons de suite y revenir), OpenAI ou Microsoft n’hésitent pas à présenter ce modèle comme un véritable pas en avant vers une “véritable” intelligence artificielle, capable de remplacer un individu sur des tâches intellectuellement complexes

- De l’autre, de nombreuses voix s’élèvent pour critiquer la méthodologie et les prétentions qui l’accompagnent (pour rappel, On the Dangers of Stochastic Parrots…, [https://dl.acm.org/doi/10.1145/3442188.3445922]

Cette nouvelle publication intervient donc dans cette ambiance un peu tendue, et n’y va pas de main morte…

De quoi parlons-nous ?

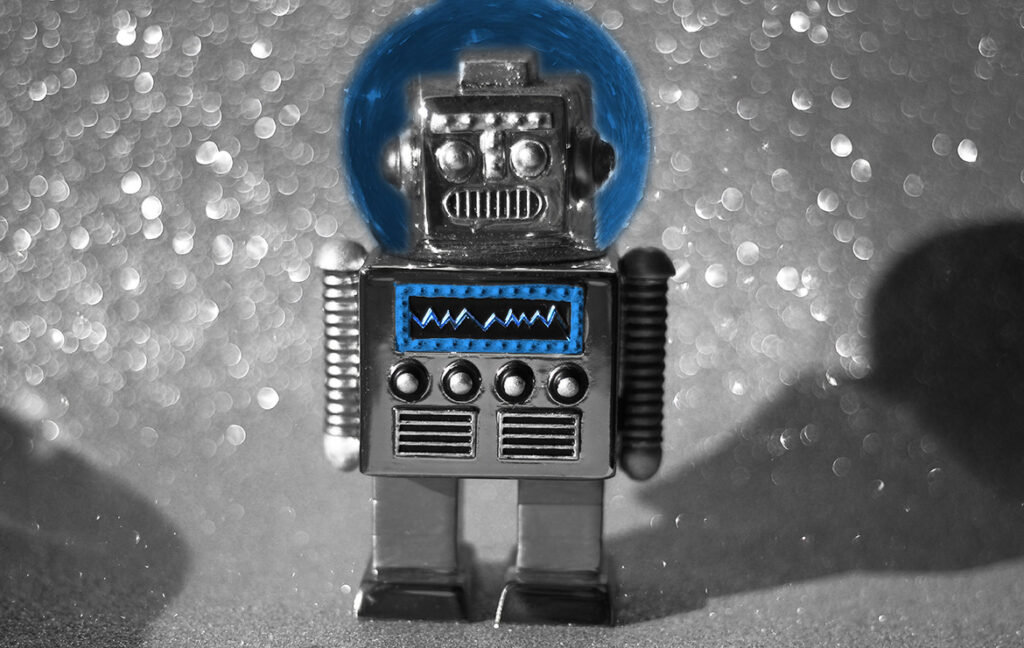

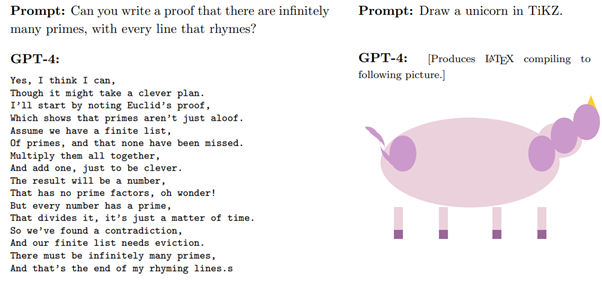

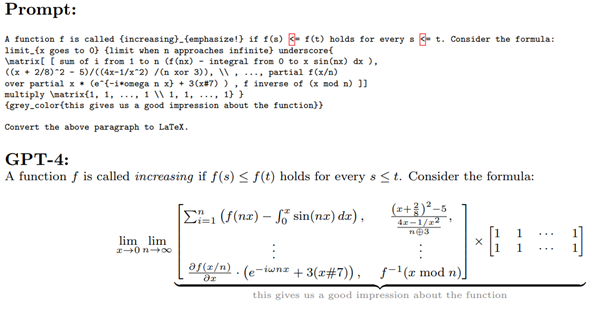

Dans ce nouveau travail, les auteurs vont très loin en affirmant que GPT4 représente effectivement une nouvelle forme d’intelligence. Les auteurs approchent de nombreuses tâches différentes pour lesquelles ils proposent une méthodologie d’analyse intéressante pour pousser le modèle dans ses retranchements. Les tests d’application sont nombreux : génération d’image au delà d’une simple mémorisation, écriture de code source informatique, mathématiques, interactions avec le monde ou avec un individu, etc. En première lecture, les résultats sont effectivement impressionnants. Ci-dessous, l’écriture d’une démonstration mathématique fondamentale en poésie, ou génération de code vectoriel permettant de dessiner un élément :

Pour reprendre un “marronnier” des modèles de langage, GPT4 pourrait ainsi demain être un développeur informatique :

Le modèle serait aussi capable de générer de la musique “originale” (ces guillemets ne sont pas là pour rien, nous en reparlons très vite) :

Sans trop vouloir prolonger une énumération un peu lourde (n’hésitez pas à lire la publication), GPT4 aurait aussi un niveau en mathématiques remarquable :

La méthodologie proposée par les auteurs est particulièrement intéressante, car elle navigue autour du problème fondamental sur lequel nous reviendrons ensuite. Les auteurs cherchent à observer si le modèle est capable d’adapter ses réponses à de nouvelles consignes et s’il peut s’adapter à de nouveaux domaines. Plus précisément, les auteurs cherchent à observer une forme de généralisation du modèle, en essayant d’échapper à une forme de résultats issus de la mémorisation du modèle. Une forme de généralisation recherchée porte sur la multi-modularité : ce modèle n’a été entraîné que sur du texte, et donc, s’il est capable de réagir à des notions sur des images sans en avoir jamais observé, nous serions face à une généralisation réelle et impressionnante.

Notons que pour les auteurs, si GPT-4 est un pas en avant, ils n’estiment pas qu’il s’agisse d’une AGI (IA générique, “true AI”), avec encore de nombreuses limitations. Ces limitations apparaissent très vite dans des problématiques liées à l’organisation, et sont l’objet d’un chapitre dédié.

Pourquoi c’est intéressant

Nous observons de plus en plus d’entreprises réfléchir à “remplacer des humains par l’IA”. Au-delà de l’effet d’annonce, il convient de questionner l’efficacité réelle que peut avoir un réseau de neurones sur de vrais problèmes. À ce titre, prétendre que ces modèles pourraient être « avocat » ou « développeur informatique » en se basant sur des scores obtenus dans des tests pose énormément question.

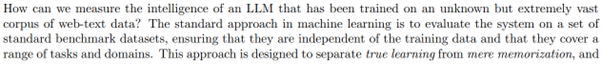

Le coeur du problème est par ailleurs levé par les auteurs :

En effet, pour juger de n’importe quel modèle Deep Learning depuis 2012, il est indispensable de pouvoir observer à quel point le modèle a appris “par coeur” des informations dans son ensemble d’entraînement, et donc à quel point il est capable de générer de nouvelles réponses originales face à un nouveau problème. Pour le cas des tests de code, des problèmes mathématiques ou des examens d’avocats, si le modèle a rencontré ces cas de figure un grand nombre de fois dans son ensemble d’entraînement, sa “réussite” sera fortement nuancée, et il sera condamné à échouer face à un problème réellement nouveau.

Hors, et c’est ici l’immense problème relevé par la publication sur les Stochastic Parrots, nous ne connaissons pas le dataset utilisé par OpenAI pour ses entraînements. OpenAI refuse en effet de communiquer ces informations sans lesquelles nous ne pouvons pas juger de la qualité du modèle.

Cette absence d’information est un préjudice énorme dans le monde de la recherche, où un travail d’un chercheur n’a de valeur que si il a été critiqué et reproduit par d’autres chercheurs. Cette opacité est une politique assumée d’OpenAI qui pose question. En effet, nous ignorons à quel point GPT4 a ce que l’on appelle un “poisoned dataset”.

Attention : cette observation ne ruine pas totalement l’intérêt de GPT4. Le simple fait d’apprendre à résumer une quantité énorme d’informations pour les ré-utiliser est une prouesse remarquable, et les modèles de langage apprennent clairement des modélisations de haut niveau de l’information qui leur permettent de transférer / adapter des tâches facilement. Et quand bien même l’hypothèse du “poisoned dataset” serait valide, ce modèle resterait un outil fascinant qui condense d’une manière incomprise une somme incroyable de connaissances. Nous ne comprenons pas aujourd’hui ce qu’est fondamentalement un modèle de langage. Il est regrettable d’observer aujourd’hui un tel bruit marketing qui nous empêche d’avoir le recul nécessaire pour juger de la qualité de ces outils. Rappelons que les auteurs sont tous issus de Microsoft qui paie très cher sa collaboration avec OpenAI pour prendre un leadership sur l’intelligence artificielle…

Sous tous les angles : un espace d’embedding pour toutes les modalités

La donnée peut avoir de nombreuses formes : image, vidéo, son, texte, etc. Un espace d’embedding est un outil par lequel on peut simplifier une donnée pour la remplacer par un vecteur beaucoup plus simple. Tout travail Deep Learning vise, implicitement, à apprendre un tel espace : un classifieur d’image apprendra à résumer une image en un vecteur plus simple, comme ChatGPT apprendra à transformer chaque élément d’une phrase en un tel vecteur.

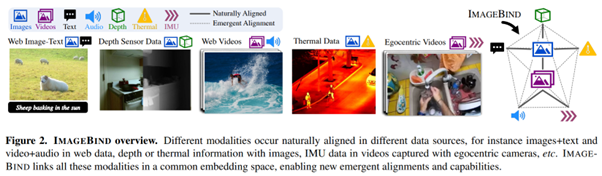

Dans un travail récent, IMAGEBIND: One Embedding Space To Bind Them All, Girdhar et al, [https://arxiv.org/abs/2305.05665], les équipes de MetaAI ont frappé un grand coup qui ne peut que nous intéresser.

Que se passe-t-il?

Ici, les auteurs entraînent un modèle qui vise à rassembler plusieurs modalités dans un même espace : images, vidéo, audio, texte, son, carte de profondeur, IMUs, images thermiques, etc. L’enjeu est de pouvoir rapprocher deux modalités visant le même contexte : le bruit du feu, une image de feu, un texte décrivant un feu, etc. Le modèle apprend donc à projeter chaque donnée dans un espace de “concepts” (terme à prendre ici à la légère) pour ensuite travailler d’une modalité à l’autre.

Ce qui est fascinant est qu’ici, les auteurs n’ont pas forcément de liens entre toutes les modalités, mais uniquement certains liens, comme de texte à image, de son à vidéo, etc. Le modèle apprend pourtant visiblement à travailler de n’importe quelle modalité vers toute autre modalité.

Une fois le modèle entraîné, ils ont pu ensuite le tester sur un grand nombre d’applications, ce type d’approche étant par nature très générique (nous y revenons ensuite), par exemple :

- Classification de son ou de mouvement par IMU

- Récupération d’un contenu par une description textuelle

- Génération de contenu contrôlé par un autre contenu (exemple ci-dessous) :

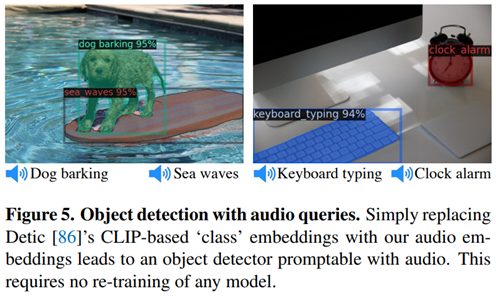

- Détection d’éléments à partir de sons pour cibler un élément :

Pourquoi c’est intéressant

Nous faisons du Deep Learning depuis assez longtemps pour savoir que l’enjeu fondamental dans l’entraînement d’un modèle est celui d’apprendre une réduction de dimension satisfaisante sur la donnée. Cet apprentissage peut être fait implicitement en entraînant un modèle, mais travailler sur des backbones spécifiques est souvent intéressant. Au-delà, l’apprentissage d’un espace d’embeddings est un outil fondamental pour pouvoir travailler sur une nouvelle donnée, particulièrement pour des approches de clustering ou de détection d’anomalies.

Ici, nous avons déjà une approche qui nous offre de nouveaux outils simples à paramétrer, quand bien même nous manquons de recul pour analyser la qualité de ces outils face à des challengers plus simples mais potentiellement plus efficaces. Nous avons surtout une boite à outils qui nous permet de directement travailler sur de nombreuses formes de la donnée. Et l’apprentissage multi-modal enrichit fortement l’information que nous pourrons extraire sur, par exemple, une carte de profondeur ou un enregistrement audio. Ce type d’approche est une petite révolution pour les travaux exploratoires de la donnée où la capacité à transférer l’information et à réduire sa complexité sont les nerfs de la guerre.

Rédacteur Eric Debeir – Directeur technique de Datalchemy